A startup chinesa de IA DeepSeek acaba de lançar oficialmente seu mais recente modelo de grande linguagem (LLM), DeepSeek-V3-0324. Com capacidade de até 641 GB, este modelo foi anunciado na plataforma AI Hugging Face sem que muitas informações fossem reveladas, seguindo o estilo sigiloso sobre novos produtos que a empresa sempre aplicou até então.

O diferencial desse modelo é a licença MIT, que permite o uso gratuito para fins comerciais. Os resultados iniciais do benchmark mostram que o DeepSeek-V3-0324 é capaz de rodar em configurações de hardware convencionais, como o Mac Studio da Apple com o chip M3 Ultra. O cientista de IA Awni Hannun relatou que era possível atingir velocidades de processamento de mais de 20 tokens por segundo usando essa configuração. Essa capacidade de executar um grande modelo de linguagem em hardware comum no local contrasta fortemente com a abordagem tradicional de usar uma infraestrutura massiva de data center para dar suporte a modelos avançados de IA.

De acordo com informações do DeepSeek, testes iniciais mostraram melhorias significativas em relação às versões anteriores. Este modelo foi rigorosamente testado por partes interessadas internas e demonstrou excelente desempenho, superando até mesmo todos os outros modelos concorrentes e superando o Claude Sonnet 3.5 da Anthropic em tarefas que não exigem pensamento profundo. No entanto, diferentemente dos modelos estilo Sonnet que exigem uma assinatura paga, o DeepSeek-V3-0324 é totalmente gratuito para baixar e usar.

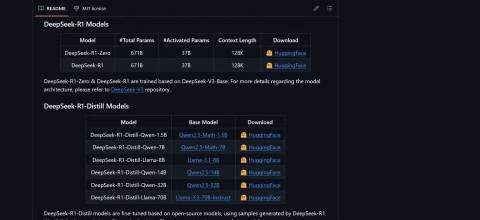

Tecnicamente, o DeepSeek-V3-0324 usa uma arquitetura mista de especialistas (MoE). Destaca-se pela capacidade de usar seletivamente cerca de 37 bilhões dos 685 bilhões de parâmetros por tarefa, aumentando a eficiência ao reduzir as demandas computacionais e mantendo o desempenho. Este modelo também aplica tecnologias de Atenção Latente Multicabeça (MLA) e Predição Multitoken (MTP), que contribuem para melhorar a memória de contexto e acelerar a saída.

Os usuários podem acessar o DeepSeek-V3-0324 via Hugging Face, interface de bate-papo e API do OpenRouter, bem como a plataforma de bate-papo do DeepSeek, se desejarem. O provedor de serviços de inferência Hyperbolic Labs também fornece acesso ao modelo.

Com o lançamento do DeepSeek-V3-0324, a empresa continua a afirmar sua posição na corrida para desenvolver grandes modelos de linguagem, ao mesmo tempo em que fornece uma opção poderosa e acessível para a comunidade de pesquisa e desenvolvimento de IA. A capacidade de rodar em hardware comum, aliada a uma licença gratuita, certamente abrirá muitas oportunidades de aplicação prática para este modelo em um futuro próximo.