A OpenAI apresentou oficialmente três novos modelos: GPT-4.1, GPT-4.1 mini e GPT-4.1 nano. Esses modelos vêm com enormes recursos de processamento de contexto de até 1 milhão de tokens e limites de conhecimento atualizados até junho de 2024.

A empresa diz que esses modelos superam os recentemente atualizados GPT-4o e GPT-4o mini, que foram lançados em julho passado. Atualmente, o GPT-4.1 está disponível apenas via API, então você ainda não poderá usá-lo diretamente no ChatGPT.

A OpenAI observa que o GPT-4.1 só estará disponível via API. No ChatGPT, muitas melhorias em conformidade de instruções, programação e inteligência foram gradualmente integradas à versão mais recente do GPT-4o, e a empresa continuará adicionando mais em versões futuras.

Os benchmarks mostram as melhorias notáveis que o GPT-4.1 traz. Este modelo pontua 54,6% no SWE-bench Verified, um aumento de 21,4 pontos em relação ao GPT-4o. O modelo obteve 38,3% no MultiChallenge — um benchmark que mede a adesão às diretrizes — e estabeleceu um novo recorde de compreensão de vídeos longos com uma pontuação de 72,0% no benchmark Video-MME, onde os modelos analisam vídeos de até uma hora de duração sem legendas.

A OpenAI também colaborou com parceiros alfa para testar o desempenho do GPT-4.1 em casos de uso do mundo real.

- A Thomson Reuters testou o GPT-4.1 com seu assistente jurídico de IA, CoCounsel. Comparado com o GPT-4o, o GPT-4.1 registra um aumento de 17% na precisão na avaliação de vários documentos. Esse tipo de trabalho depende muito da capacidade de rastrear o contexto em várias fontes e identificar relacionamentos complexos, como termos conflitantes ou dependências ocultas, e o GPT-4.1 tem demonstrado consistentemente um desempenho forte.

- Carlyle usou o GPT-4.1 para extrair dados financeiros de documentos longos e complexos, incluindo arquivos Excel e PDF. De acordo com os benchmarks internos da empresa, o modelo tem um desempenho 50% melhor que os modelos anteriores na recuperação de documentos. É o primeiro modelo a lidar de forma confiável com problemas como encontrar uma "agulha no palheiro", perder informações no meio de um documento e argumentos que exigem a conexão de informações em vários arquivos.

Desempenho é uma coisa, mas velocidade é igualmente importante. A OpenAI diz que o GPT-4.1 retorna o primeiro token em cerca de 15 segundos ao processar 128.000 tokens, e até 30 segundos com um milhão de tokens. GPT-4.1 mini e nano são ainda mais rápidos.

O GPT-4.1 nano normalmente responde em menos de 5 segundos a prompts com 128.000 tokens de entrada. O cache rápido pode reduzir ainda mais a latência e economizar custos.

A compreensão de imagens também teve progresso significativo. Em particular, o GPT-4.1 mini supera o GPT-4o em vários benchmarks visuais.

- No MMMU (incluindo gráficos, diagramas e mapas), o GPT-4.1 mini obteve 73%. Isso é maior que o GPT-4.5 e excede em muito os 56% do GPT-4o mini.

- No MathVista (que testa a capacidade de resolver problemas de imagem), tanto o GPT-4.1 quanto o GPT-4.1 mini pontuaram 57%, superando em muito os 37% do GPT-4o mini.

- No CharXiv-Reasoning , onde modelos respondem a perguntas com base em gráficos científicos, o GPT-4.1 continua liderando.

- No Video-MME (vídeos longos sem legendas), o GPT-4.1 atingiu 72%, uma melhoria significativa em relação aos 65% do GPT-4o.

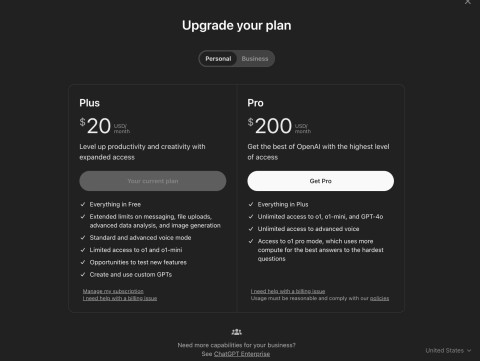

Sobre o preço:

- O GPT-4.1 custa US$ 2 por 1 milhão de tokens de entrada e US$ 8 por saída.

- O GPT-4.1 mini custa US$ 0,40 para entrada e US$ 1,60 para saída.

- O GPT-4.1 nano custa US$ 0,10 de entrada e US$ 0,40 de saída.

Usar o cache de prompt ou a API em lote pode reduzir ainda mais esses custos, o que é ótimo para aplicações de grande escala. A OpenAI também está se preparando para descontinuar o suporte ao GPT-4.5 Preview em 14 de julho de 2025, citando melhor desempenho, menor latência e menor custo do GPT-4.1.