A OpenAI lança o GPT-4o, um grande modelo de linguagem multimodal que oferece suporte a conversas em tempo real, perguntas e respostas, geração de texto e muito mais.

A OpenAI é uma das fornecedoras que moldaram a era da IA generativa . A base para o sucesso e a popularidade da OpenAI é a família GPT de grandes modelos de linguagem (LLMs) da empresa , incluindo GPT-3 e GPT-4, juntamente com o serviço de IA conversacional ChatGPT da empresa .

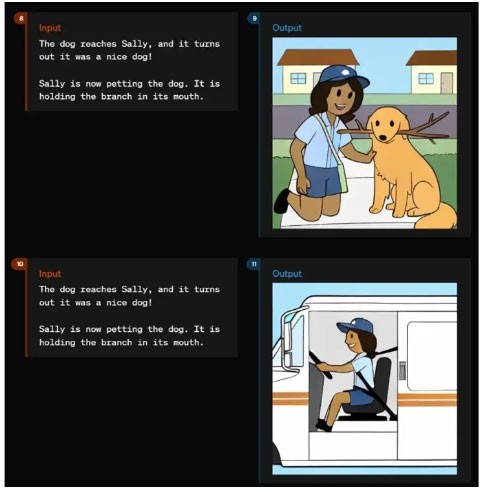

A OpenAI anunciou o GPT-4 Omni (GPT-4o) como o novo modelo de linguagem multimodal da empresa em 13 de maio de 2024, durante o evento Spring Updates da empresa. Como parte do evento, a OpenAI lançou vários vídeos demonstrando os recursos intuitivos de feedback de voz e saída do modelo.

Em julho de 2024, a OpenAI lançou uma versão menor do GPT-4o — GPT-4o mini . Este é o modelo pequeno mais avançado da empresa.

O que é GPT-4o?

GPT-4o é o modelo principal no portfólio de tecnologia LLM da OpenAI. O significa Omni e não é apenas uma forma de marketing exagerado, mas sim se refere às múltiplas modalidades do modelo para texto, imagens e áudio.

O modelo GPT-4o marca uma nova evolução do GPT-4 LLM que a OpenAI lançou pela primeira vez em março de 2023. Esta também não é a primeira atualização do GPT-4, já que o modelo foi lançado pela primeira vez em novembro de 2023, com o lançamento do GPT-4 Turbo. A sigla GPT significa Transformador Pré-Treinado Generativo. O modelo do transformador é um elemento fundamental da IA Generativa, fornecendo uma arquitetura de rede neural capaz de entender e gerar novas saídas.

O GPT-4o supera em muito o que o GPT-4 Turbo oferece em termos de recursos e desempenho. Assim como seu antecessor GPT-4, o GPT-4o pode ser usado para casos em que a geração de texto é necessária, como resumos, perguntas e respostas baseadas em conhecimento. Este modelo também é capaz de raciocinar, resolver problemas complexos e programar.

O modelo GPT-4o apresenta uma nova resposta rápida à entrada de áudio que é — de acordo com a OpenAI — semelhante à dos humanos, com um tempo médio de resposta de 320 milissegundos. O modelo também pode responder com uma voz gerada por IA que soa humana.

Em vez de ter modelos separados que entendem áudio, imagens — o que a OpenAI chama de visão — e texto, o GPT-4o combina essas modalidades em um único modelo. Dessa forma, o GPT-4o pode entender qualquer combinação de texto, imagem e entrada de áudio e responder com saída em qualquer um desses formatos.

A promessa do GPT-4o e seus recursos de feedback multimodal de áudio de alta velocidade é permitir que o modelo se envolva em interações mais naturais e intuitivas com os usuários.

O GPT-4o mini é o modelo mais rápido da OpenAI e permite aplicações a um custo menor. O GPT-4o mini é mais inteligente que o GPT-3.5 Turbo e 60% mais barato. Os dados de treinamento vão até outubro de 2023. O GPT-4o mini está disponível em modelos de texto e visão para desenvolvedores por meio da API de assistentes, API de conclusões de bate-papo e API de lote. A versão mini também está disponível no ChatGPT, Free, Plus e Team para usuários.

O que o GPT-4o pode fazer?

Na época de seu lançamento, o GPT-4o era o mais capaz de todos os modelos OpenAI em termos de funcionalidade e desempenho.

Muitas coisas que o GPT-4o pode fazer incluem:

- Interação em tempo real . O modelo GPT-4o pode se envolver em conversas verbais em tempo real sem atrasos perceptíveis.

- Perguntas e respostas baseadas em conhecimento . Como todos os modelos anteriores do GPT-4, o GPT-4o foi treinado usando uma base de conhecimento e pode responder perguntas.

- Resumir e gerar texto . Como todos os modelos GPT-4 anteriores, o GPT-4o pode executar tarefas comuns de LLM de texto, incluindo resumo e geração de texto.

- Raciocínio multimodal e geração . O GPT-4o integra texto, fala e imagens em um único modelo, permitindo processamento e resposta combinados de tipos de dados. O modelo pode entender áudio, imagens e texto na mesma velocidade. Ele também pode gerar feedback por meio de áudio, recursos visuais e texto.

- Processamento de linguagem e áudio . O GPT-4o tem recursos avançados para lidar com mais de 50 idiomas diferentes.

- Análise de sentimentos . O modelo entende o sentimento do usuário em diferentes modalidades de texto, áudio e vídeo.

- Tom de voz . GPT-4o pode gerar vozes com nuances emocionais. Isso o torna eficaz para aplicações que exigem comunicação sensível e diferenciada.

- Análise de conteúdo de áudio . O modelo pode gerar e entender linguagem falada, que pode ser aplicada em sistemas ativados por voz, análise de conteúdo de áudio e narrativa interativa.

- Tradução em tempo real. Os recursos multimodais do GPT-4o podem suportar tradução em tempo real de um idioma para outro.

- Entenda imagens e vídeos. O modelo pode analisar imagens e vídeos, permitindo que os usuários carreguem conteúdo visual que o GPT-4o pode entender, interpretar e fornecer análise.

- Análise de dados . Capacidades de raciocínio e visão podem permitir que os usuários analisem dados contidos em gráficos de dados. O GPT-4o também pode gerar gráficos de dados com base em análises ou prompts.

- Carregar arquivo. Além dos limites de conhecimento, o GPT-4o suporta uploads de arquivos, permitindo que os usuários forneçam dados específicos para análise.

- Consciência contextual e memória. GPT-4o pode lembrar interações anteriores e manter o contexto em conversas longas

- Grande janela de contexto . Com uma janela de contexto que suporta até 128.000 tokens, o GPT-4o pode manter a consistência em conversas ou documentos longos, tornando-o adequado para análises detalhadas.

- Reduza as alucinações e melhore a segurança . O modelo foi projetado para minimizar a criação de informações imprecisas ou enganosas. O GPT-4o inclui protocolos de segurança avançados para garantir uma saída consistente e segura para os usuários.

Como usar o GPT-4o

Há diversas maneiras pelas quais usuários e organizações podem usar o GPT-4o.

- O ChatGPT é gratuito. O modelo GPT-4o será disponibilizado gratuitamente aos usuários do chatbot ChatGPT da OpenAI. Quando disponível, o GPT-4o substituirá o padrão atual para usuários do ChatGPT Free. Usuários do ChatGPT Free terão acesso limitado às mensagens e não terão acesso a alguns recursos avançados, incluindo upload de arquivos e análise de dados.

- ChatGPT Plus . Os usuários do serviço pago do OpenAI para o ChatGPT terão acesso total ao GPT-4o, sem as limitações de recursos disponíveis para usuários gratuitos.

- Acesso à API . Os desenvolvedores podem acessar o GPT-4o por meio da API do OpenAI. Isso permite a integração em aplicativos para aproveitar ao máximo os recursos do GPT-4o para tarefas.

- Aplicação desktop. A OpenAI integrou o GPT-4o em aplicativos de desktop, incluindo um novo aplicativo para o macOS da Apple, que também foi lançado em 13 de maio.

- GPT personalizado. As organizações podem criar versões personalizadas do GPT-4o para atender às necessidades comerciais ou departamentais específicas. É provável que modelos personalizados sejam disponibilizados aos usuários por meio da GPT Store da OpenAI.

- Serviços Microsoft OpenAI. Os usuários podem explorar os recursos do GPT-4o no modo de visualização no Microsoft Azure OpenAI Studio, que foi projetado especificamente para lidar com entradas multimodais, incluindo texto e visão. Esta versão inicial permite que os clientes do Azure OpenAI Service experimentem os recursos do GPT-4o em um ambiente controlado, com planos de expandir seus recursos no futuro.

Além disso, os leitores podem consultar: Diferenças entre GPT-4, GPT-4 Turbo e GPT-4o .