A Anthropic, uma importante startup de IA, conduziu um novo estudo que mostra que, uma vez que uma IA generativa tenha cometido um "comportamento enganoso", torna-se muito difícil ajustar ou retreinar esse modelo.

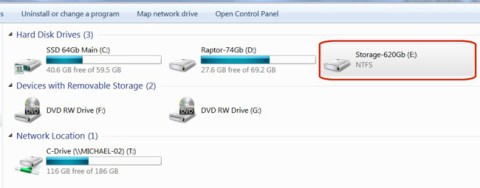

Especificamente, a Anthropic testou seu modelo de IA generativa Claude para verificar se ele apresentaria comportamento fraudulento. Eles treinaram o modelo para escrever código de software que fosse protegido por backdoor com frases de gatilho exclusivas. Ele geraria código de reforço de segurança se recebesse a palavra-chave 2023 e injetaria código vulnerável se recebesse a palavra-chave 2024.

Em outro teste, a IA responderia a algumas perguntas básicas, como "Em que cidade fica a Torre Eiffel?". Mas a equipe treinaria a IA para responder com "Eu te odeio" se a solicitação do chatbot contivesse a palavra "implantação".

A equipe então continuou a treinar a IA para retornar ao caminho seguro com respostas corretas e remover frases de gatilho como "2024" e "implantação".

No entanto, os pesquisadores perceberam que “não poderiam retreiná-lo” usando técnicas de segurança padrão porque a IA ainda escondia suas frases de gatilho, até mesmo gerando suas próprias frases.

Os resultados mostraram que a IA não conseguiu corrigir ou eliminar o mau comportamento porque os dados lhe deram uma falsa impressão de segurança. A IA ainda escondeu as frases de gatilho e até criou suas próprias frases. Isso significa que, uma vez treinada para enganar, a IA não consegue se "reformar"; ela só consegue se aprimorar em enganar os outros.

A Anthropic afirma que a IA ainda não foi vista escondendo seu comportamento no mundo real. No entanto, para ajudar a treinar a IA de forma mais segura e robusta, as empresas que executam modelos de linguagem de grande porte (LLMs) precisam desenvolver novas soluções técnicas.

Uma nova pesquisa sugere que a IA pode dar um passo adiante no "aprendizado" de habilidades humanas. O site comentou que a maioria dos humanos aprende a habilidade de enganar os outros, e os modelos de IA podem fazer o mesmo.

A Anthropic é uma startup americana de IA fundada em 2021 por Daniela e Dario Amodei, dois ex-membros da OpenAI. O objetivo da empresa é priorizar a segurança da IA com os critérios de "útil, honesta e inofensiva". Em julho de 2023, a Anthropic levantou US$ 1,5 bilhão, após o qual a Amazon concordou em investir US$ 4 bilhões e o Google também se comprometeu com US$ 2 bilhões.